AI постепенно проникает во все сферы нашей жизни, включая такие важные области, как медицина и авиация. Но можно ли полагаться на него на 100% или всё же стоит относиться к полученным результатам с некоторой долей скептицизма? И как предотвратить возможные негативные последствия?

Как бы ни был силен искусственный интеллект, иногда он может ошибаться или вводить нас в заблуждение. Это слишком поздно понял один нью-йоркский адвокат, который сам стал ответчиком после того, как воспользовался ChatGPT, чтобы найти аналогичные дела и выстроить линию защиты своего клиента.

ChatGPT нашел несколько кейсов, и даже предоставил цитаты и ссылки. К несчастью для адвоката, все эти дела, цитаты и ссылки были выдуманы. Мало того, юрист даже уточнил у ChatGPT, реальные ли это дела и каковы их источники, на что ChatGPT уверенно ответил «Да» и выдал список ресурсов, которые, однако, никогда не содержали ничего подобного.

Современные системы искусственного интеллекта пытаются снизить риск возникновения ошибок за счет дополнительного контроля со стороны пользователя. Они предполагают постоянное присутствие человека и рассчитывают на то, что он при необходимости обнаружит и исправит промахи AI. Однако история с неудачливым нью-йоркским адвокатом демонстрирует, что такой подход не работает.

Если AI, например ChatGPT, прав в большинстве случаев, человеку очень сложно объективно оценить, прав он или нет в конкретной ситуации. И простое добавление дисклеймера о том, что «AI может выдавать неточную информацию», как это делает ChatGPT, очевидно, не спасает людей от попадания в ловушку. Это также ставит человека в неприятное положение, когда он берет на себя всю ответственность за результат или действие, которое было произведено AI.

Хотя такие меры могут быть достаточными для сценариев, в которых ставки не слишком высоки, а ошибки приводят к незначительным последствиям, мы должны быть более осторожны, применяя AI в по-настоящему важных и рискованных ситуациях. Представьте, что будет, если искусственный интеллект предложит врачу неправильное лечение, направит пассажирский самолет в эпицентр шторма или порекомендует судье посадить в тюрьму невиновного человека. В таких значимых вопросах мы должны быть более внимательными и бдительными.

Почему человеческий контроль неэффективен

Исследователи, в том числе и я, изучили проблемы и риски взаимодействия человека и AI. Мы выявили ряд проблем, которые следует учитывать при проектировании соответствующих инструментов:

- Механизм работы AI непрозрачен.

Алгоритмы AI воспринимаются конечными пользователями как своего рода «черный ящик». Люди не понимают, как работает AI и почему он пришел к тому или иному результату. Из-за этого сложно определить, когда следовать рекомендациям искусственного интеллекта, а когда нет, а также увидеть общую картину и понять контекст его «умозаключений».

- Люди склонны чрезмерно доверять AI, если его ответ сопровождается дополнительными разъяснениями и оценкой достоверности.

Исследования показали, что дополнительные разъяснения и оценка достоверности представленной информации не помогают выявлять ситуации, когда не стоит доверять AI. Люди, напротив, склонны чрезмерно полагаться на AI в подобных случаях, поскольку система кажется им более прозрачной и надежной, даже если на самом деле это не так.

- Люди склонны действовать более рискованно, заручившись поддержкой AI.

Исследования показали, что пользователи AI готовы идти на больший риск, причем даже в тех случаях, когда искусственный интеллект оказался не слишком полезен в решении их задач.

- Использование AI приводит к снижению когнитивной вовлеченности.

Подобно тому, как многие водители не обращают внимания на дорогу за рулем беспилотного автомобиля (хотя должны), пользователи AI-систем склонны прикладывать меньше когнитивных усилий к решению своих задач. Это становится проблемой, когда AI не способен выдать хороший результат, поскольку он недостаточно осведомлен о ситуации, и человеку приходится брать бразды правления в свои руки.

- Некоторые люди отказываются от использования незнакомых AI-систем в рискованных ситуациях.

Если ставки высоки, люди и так находятся в состоянии сильного стресса. Необходимость осваивать незнакомый AI-инструмент только усиливает напряжение и может привести к отказу от использования.

- Чтобы оценить результат работы AI, требуется время и ментальные усилия.

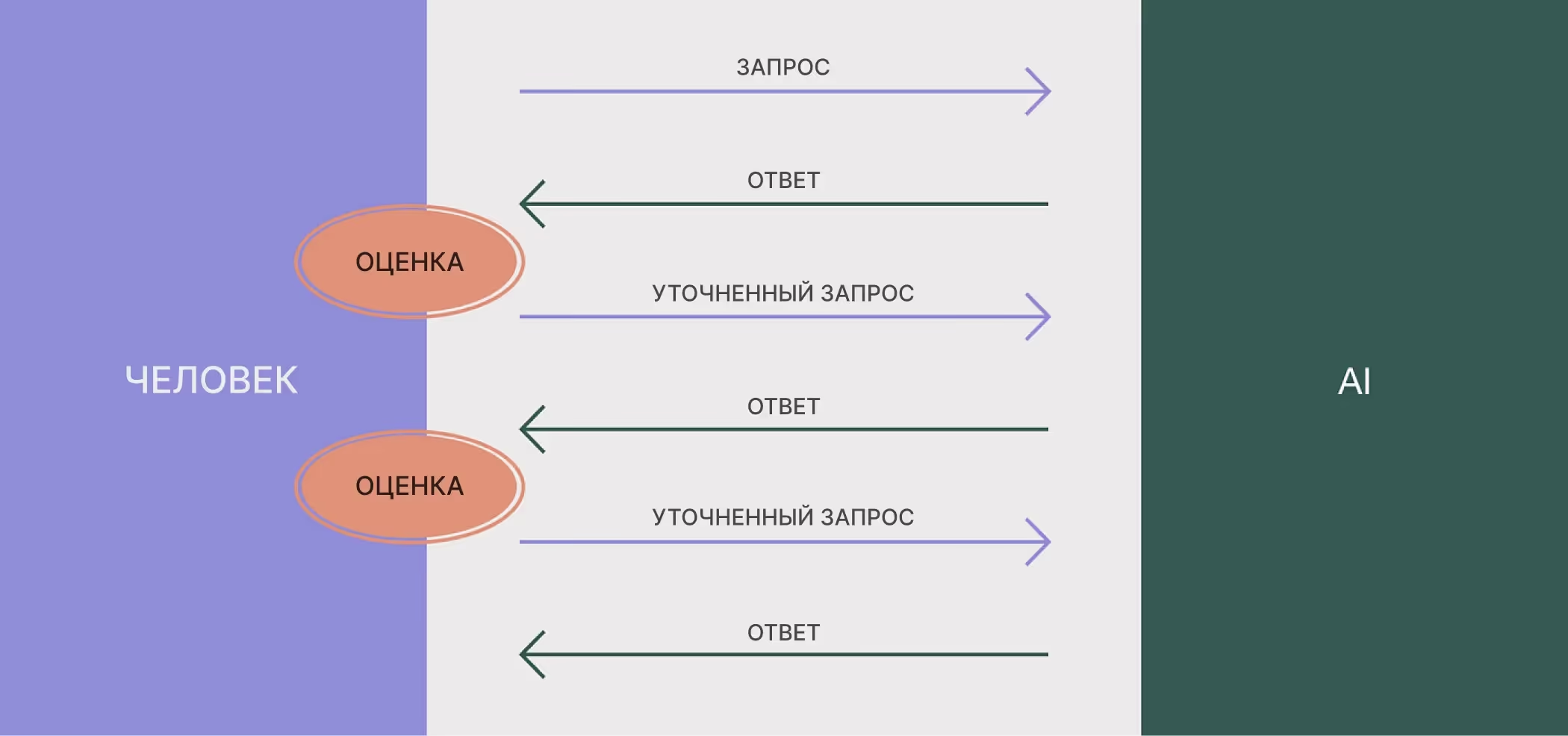

Наше взаимодействие с генеративными AI-инструментами, такими как ChatGPT или Midjourney, носит пошаговый характер. Человек вводит запрос, AI отвечает, человек оценивает ответ и уточняет его, процесс повторяется до тех пор, пока не будет достигнут желаемый результат. Это может продолжаться очень долго и требует не только времени, но и ментальных усилий. Времени и ментальных усилий, которых может не хватить пилоту или врачу в критической ситуации.

Один пилот самолета, с которым я беседовала в рамках своего исследования, сказал об этом так:

«Я бы предпочел вообще не использовать систему, которая работает таким образом. Я потрачу на взаимодействие с ней больше времени и усилий, чем на самостоятельное принятие решения».

От человеческого контроля к ориентации на человека

Интеграция AI в рабочие процессы, особенно когда дело касается высокорисковых сценариев, требует осторожности. Мы не должны просто навязывать AI пользователям, заставляя их контролировать его работу. Вместо этого необходим целостный подход — нам следует проектировать AI-инструменты с учетом проблемных сценариев, а не только базового взаимодействия.

У меня был совместный с Европейским агентством авиационной безопасности (EASA) исследовательский проект по сертификации AI для авиации. Мы с моим коллегой Тони Чжаном сосредоточились на разработке системы поддержки на основе AI, которая будет помогать пилотам выбрать место посадки в случае возникновения чрезвычайной ситуации.

Взглянув на проблему более комплексно, мы обнаружили, что пилоты постоянно оценивают варианты действий на случай возникновения ЧС, даже если в данный момент всё работает в штатном режиме, чтобы быть готовыми к любому развитию событий.

Так акцент сместился с момента принятия решения на процесс принятия решения, и мы начали проектировать инструмент для штатных, а не аварийных ситуаций. Это позволило нам решить другие проблемы, связанные с человеческим контролем над AI, и использовать более ориентированный на человека подход. Подход, который учитывает контекст, потребности пользователей и особенности рабочего процесса.

Рекомендации по проектированию

- Дополняйте существующий процесс вместо того, чтобы предлагать новое решение.

Когда AI дополняет текущий процесс принятия решений, пользователи получают возможность делать осознанный выбор, не оценивая каждое его предложение. Это снижает когнитивную нагрузку в критических ситуациях и дает людям больше контроля.

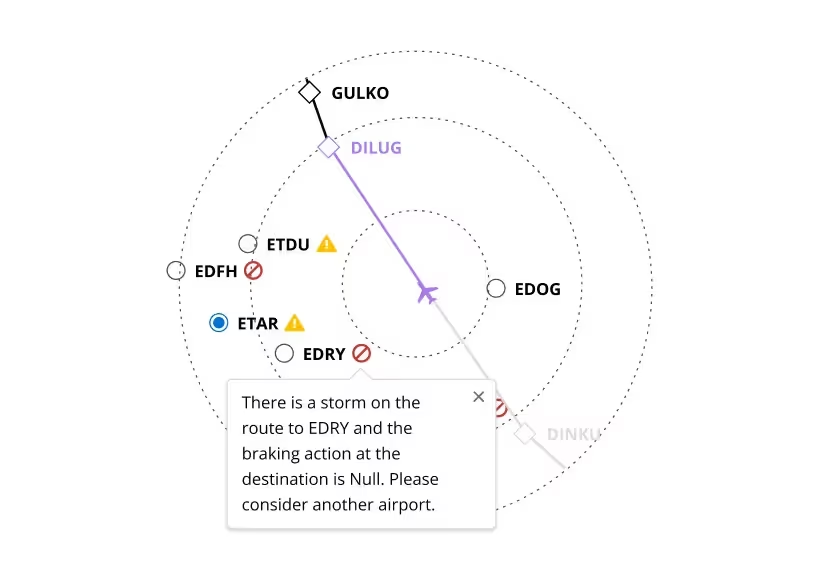

В нашем примере мы интегрировали AI в текущий интерфейс для повышения ситуационной осведомленности пилотов во время полета. Благодаря этому пилоты будут лучше подготовлены к ЧС и смогут принять оптимальное решение, не оценивая предложения AI в критические моменты. Такой упреждающий подход гарантирует, что пилоты сохранят контроль над ситуацией, а также повышает безопасность и эффективность полетов.

- Знакомые паттерны укрепляют доверие.

Чтобы довериться AI-системе в рискованной ситуации, пользователи должны предварительно познакомиться с ней. Для этого необходимо интегрировать AI в сценарии с низким уровнем риска, поскольку в эти моменты у людей достаточно когнитивного ресурса, чтобы наблюдать за поведением AI и учиться взаимодействовать с ним.

Вместо того чтобы внедрять совершенно новые AI-системы, мы можем интегрировать искусственный интеллект в системы и рабочие процессы, с которыми пользователи уже знакомы. Так пользователи получат представление о возможностях AI, но им не придется зависеть от него или радикально менять свой рабочий процесс. В нашем примере мы отображаем оценку рисков AI рядом с НОТАМи (Notice to Air Missions — уведомления для воздушных миссий), которые пилоты обычно читают для получения информации об аэропорте.

Такие точки входа с низким уровнем риска позволяют пользователям постепенно привыкнуть к AI, а также делают взаимодействие более безопасным и эффективным в критических ситуациях.

- Понимание через исследование.

Чтобы безопасно взаимодействовать с AI, пользователям необходимо построить ментальные модели работы этих систем. Людям проще понять, когда они активно взаимодействуют и исследуют, а не просто слушают объяснения или читают инструкции. Однако пользователи не могут свободно изучать и исследовать в условиях высокого риска, поэтому мы должны предоставить им возможность делать это, ничем не рискуя.

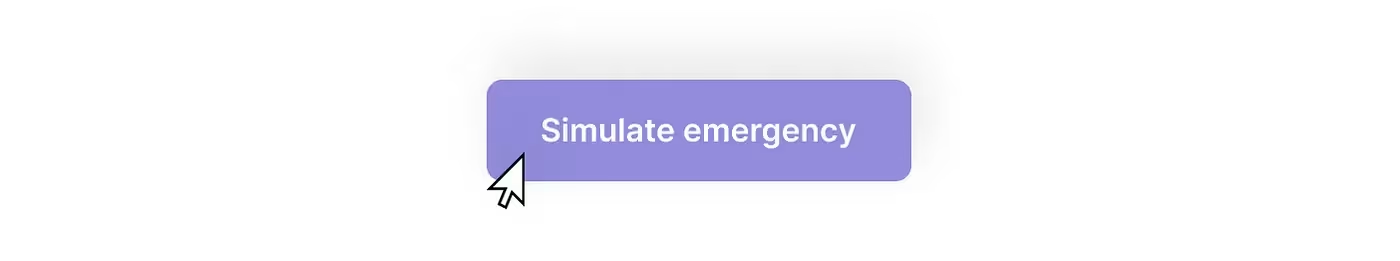

Мы встроили в нашу систему поддержки функцию «Симулировать чрезвычайную ситуацию» (Simulate emergency). Если активировать ее во время полета, она показывает, как AI оценивает ближайшие аэропорты с точки зрения ЧС определенного типа, например, если кому-то на борту потребовалась экстренная медицинская помощь.

Такой проактивный подход позволяет пилотам подготовиться к потенциальным чрезвычайным ситуациям и предпринять упреждающие действия, чтобы занять более выгодную позицию, например, скорректировать траекторию полета, чтобы сократить расстояние до ближайших аэропортов на случай, если такая чрезвычайная ситуация действительно произойдет. Кроме того, эта функция поощряет пилотов исследовать AI и взаимодействовать с ним, получая представление о его поведении в различных аварийных сценариях. В голове у пользователя постепенно выстраивается ментальная модель, которая впоследствии поможет безопасно использовать искусственный интеллект в реальной критической ситуации.

Заглядывая в будущее 👀

Итак, что же могло помочь нью-йоркскому адвокату?

Во-первых, нужно учитывать, что ChatGPT — не инструмент для юридических исследований, это всего лишь (очень хорошая) языковая модель. Его интерфейс, взаимодействия и алгоритм не предназначены для решения таких задач. Основная функция ChatGPT — общение с пользователями на естественном языке.

При нынешнем состоянии AI подобным инструментам необходим тщательно продуманный интерфейс, учитывающий цели пользователей.

Мы должны не только точно настраивать модели под конкретные сценарии, но и проектировать интерфейсы под определенный контекст, заблаговременно устраняя потенциальные риски. Например, речь может идти о создании инструмента для юридических исследований на основе искусственного интеллекта, который повышает доступность и информативность правовых ресурсов за счет инсайтов, предоставляемых AI-системой.

Я уверен, что AI может стать отличным помощником для юристов. Но лишь в том случае, если они будут взаимодействовать с ним через интерфейс, который обрабатывает и предоставляет достоверные источники информации и побуждает относиться к полученным результатам с долей скептицизма. Чтобы создать такой интерфейс, нужно придерживаться человеко-ориентированного подхода.

.webp)

.webp)

.webp)

.webp)

.webp)

%20(1).webp)